Perché cercare Matters

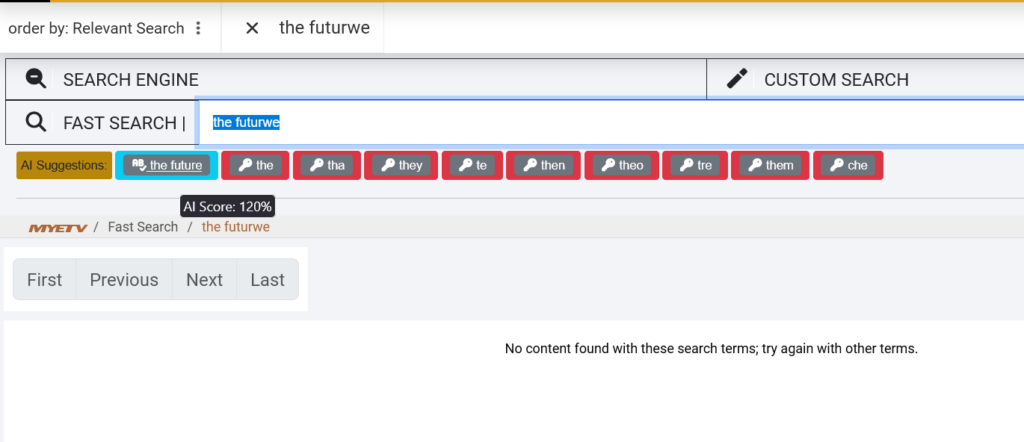

The MYETV Motore di ricerca è già uno dei motori di ricerca più sofisticati del web. La ricerca è il battito cardiaco di qualsiasi piattaforma di contenuti. È il ponte invisibile tra quello che stai pensando e quello che stai cercando di trovare. Quando si digita "la fiuture di ai" in una casella di ricerca, non si dovrebbe ottenere zero risultati solo a causa di un typo. Dovresti ottenere esattamente ciò che intendevi: “il futuro dell’IA”.

Oggi, siamo entusiasti di condividere una pietra miliare importante nel viaggio di MYETV: una revisione completa del nostro motore di ricerca alimentato da intelligenza artificiale, dizionari multilingue e elaborazione di linguaggio naturale avanzato. Questo non è solo un aggiornamento tecnico, è un cambiamento fondamentale in come MYETV ti capisce.

Immergiamo in ciò che abbiamo costruito, perché conta, e come funziona dietro le quinte.

Il problema: la ricerca tradizionale è troppo rigida

I motori di ricerca tradizionali non perdonano. Corrispondono a parole esattamente come li digiti. Se si cerca di “video miusico,” la maggior parte dei sistemi non restituirà nulla o mostrare risultati per qualcosa completamente non correlato. Non lo fannocapirelingua, corrispondono solo i modelli.

Questo diventa ancora più problematico in una piattaforma globale multilingue come MYETV, dove gli utenti parlano inglese, italiano, spagnolo, francese, tedesco, portoghese e molte altre lingue. Un utente a Roma potrebbe cercare “tutorail vidio” in inglese, mentre un altro a Madrid cerca “música” con un typo come “musica” (senza accento). I motori di ricerca tradizionali lottano con questi scenari del mondo reale.

Ci siamo chiesti:E se il nostro motore di ricerca potesse pensare come un umano?Cosa succede se potrebbe correggere la tua ortografia, comprendere il contesto, rilevare automaticamente la lingua, e anche suggerire contenuti in base a significati semantici piuttosto che a parole esatte?

Questo è esattamente quello che abbiamo deciso di costruire.

La soluzione: un sistema di ricerca a tre livelli AI-Powered

Il nostro nuovo motore di ricerca combina tre tecnologie potenti che lavorano in armonia:

1. Correzione del dizionario multilingue

2. BERT Comprensione semantica

3. Contenuti-Aware Titolo Matching

Sfondiamo ogni strato.

Livello 1: Correzione del dizionario multilingue

La Fondazione: 50.000 + parole in 20 lingue

Al centro del nostro nuovo motore di ricerca è un enorme dizionario multilingue contenente oltre50.000 parole accuratamente curateattraverso20 lingue. Questi non sono solo liste di parole casuali – sono vocabulries ponderati in frequenza che rappresentano come le persone effettivamente comunicare online.

Ecco cosa abbiamo incluso:

- Inglese: 10.000 parole più comuni

- Italiano: 10.000 parole più comuni

- Spagnolo: 10.000 parole più comuni

- Francese: 10.000 parole più comuni

- Germania: 10.000 parole più comuni

- Portoghese: 10.000 parole più comuni

- Oltre 14 lingue aggiuntive: Olandese, russo, polacco, turco, arabo, cinese (semplificato), giapponese, coreano, hindi, svedese, norvegese, danese, finlandese e greco

Ogni parola è indicizzata con la sua frequenza d'uso, il che significa che il sistema prioritizza parole comuni su quelle oscure quando suggerisce correzioni.

Da dove vengono questi dati?

Abbiamo fornito le nostre liste di parole da diversi database linguistici open source:

- Liste di frequenza Wiktionary: Elenchi delle parole più comunemente usate in ogni lingua

- OpenSubtitles corpo: Uso della lingua reale da milioni di sottotitoli di film e show TV

- Google Books Dati Ngram: Modelli linguistici storici da miliardi di libri pubblicati

- Dipendenze universali: Linguisticamente annotato testo corpora

Questa combinazione ci dà un quadro realistico di come la gente realmente scrive e ricerca, non solo le definizioni di dizionario formale.

Come funziona la correzione del dizionario

Quando si digita una query di ricerca, il nostro sistema controlla immediatamente ogni parola contro il nostro dizionario multilingue utilizzando una tecnica chiamataDistanza da Levenshtein, un modo matematico per misurare quante modifiche single-character (inserzioni, cancellazioni, sostituzioni) sono necessarie per cambiare una parola in un'altra.

Per esempio:

- “fiuture” → “futuro” (distanza: 1, una sostituzione)

- “tutorail” → “tutorial” (distanza: 1, una sostituzione)

- “vidio” → “video” (distanza: 1, una sostituzione)

Il sistema calcola queste distanze in tempo reale, cerca il nostro dizionario per le parole entro una distanza di 2, le classifica per frequenza, e suggerisce la correzione più probabile.

Ma ecco la parte intelligente: Il sistema rileva automaticamente quale lingua stai usando controllando quale dizionario ha più partite per le tue parole. Se cercate “la musica italiana” (italiano), non cercherà di correggerla in inglese, riconosce l’italiano e valida contro il dizionario italiano.

Livello 2: BERT Comprensione semantica

Cos'è BERT?

BERT stand perRappresentanze bidirezionali di Encoder dai trasformatori. È un modello di apprendimento profondo sviluppato da Google che ha rivoluzionato l'elaborazione del linguaggio naturale nel 2018. A differenza dei motori di ricerca tradizionali che corrispondono parole chiave, BERT in realtàcomprendeil significato delle parole nel contesto.

Pensate in questo modo: Se si cerca di “apple”, un motore di ricerca tradizionale non sa se si intende la frutta o la società tecnologica. BERT comprende il contesto. Se le ricerche precedenti erano circa “iPhone” e “MacBook,” BERT sa che probabilmente si intende Apple Inc.

La Biblioteca dei Transformers

Stiamo usandoBiblioteca Transformersda Hugging Face, che fornisce modelli AI pre-trained che possono comprendere e generare il linguaggio umano. In particolare, stiamo usando:

- Modello:

bert-base-uncased(un modello BERT inglese compatto ma potente) - Attività: Previsioni di Fill-Mask (indipendentemente dal contesto per suggerire parole correlate)

- Oggetto: Suggerimenti semantici oltre la correzione ortografia

Come BERT migliora la ricerca

Quando si cerca qualcosa e non troviamo partite esatte, BERT passi per suggerire termini semanticamente correlati dal nostro database di contenuti.

Per esempio:

- Voi cercate: “Blotti elettronici”

- BERT suggerisce: “musica”, “tecnologia”, “edm”, “elettronica”

- Cercate: “cooking show”

- BERT suggerisce: “recipe”, “chef”, “culinario”, “cucina”

Questo è possibile perché BERT è stato addestrato a miliardi di parole e comprende i rapporti tra concetti. Non è solo corrispondenza lettere, corrispondesignificato.

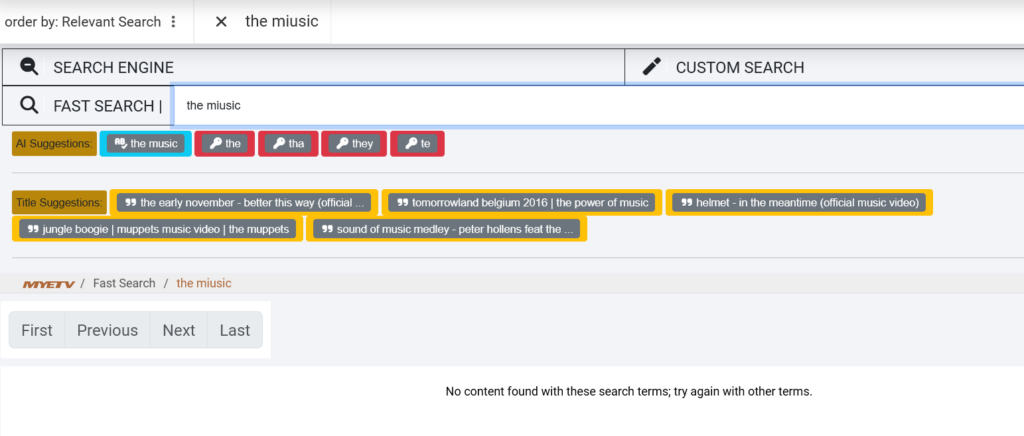

Livello 3: Contenuti-Aware Titolo Matching

Ricerca all'interno Titoli, Non solo Tag

Il terzo strato del nostro motore di ricerca guarda direttamente nella libreria di contenuti di MYETV specificatamente, i titoli e le descrizioni dei contenuti. E' qui che le cose diventano molto intelligenti.

Quando si digita una query multi-parola come “il futuro della musica”, il nostro sistema:

- Spacca la tua richiesta in parole individuali: [“the”, “future”, “of”, “musica”]

- Cerca nel nostro databaseper titoli contenenti parole simili

- Calcola un punteggio di somiglianzaper ogni titolo basato su quante delle tue parole si abbinano (anche con i tipi)

- Ranks e suggeriscei migliori titoli di gioco

Per esempio, se abbiamo un video intitolato “Il futuro della musica elettronica nel 2026,” e si cerca “la fiuture di miusico,” il sistema sarà:

- Corretto “fiuture” → “futuro”

- Corretto “miusico” → “musica”

- Abbinamento “il” e “di” esattamente

- Riconoscere il titolo come una partita del 100% e suggerirlo

Questo strato è particolarmente potente per le ricerche di lunga data — query specifiche, multi-parole che la parola chiave tradizionale corrispondenza spesso manca.

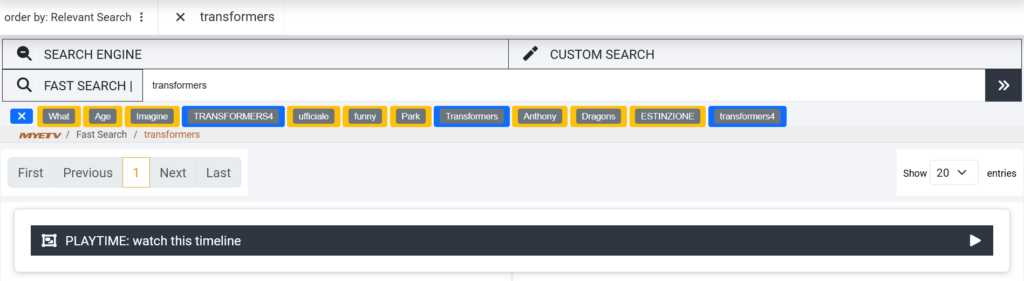

Mettere tutto insieme: l'esperienza di ricerca

Passiamo attraverso un esempio reale per vedere come tutti e tre i livelli lavorano insieme.

Scenario: Cercate “la fiuture di miusico”

Passo 1: Correzione del dizionario (livello 1)

Il sistema rileva:

- “il” → parola inglese valida ✓

- “fiuture” → parola non valida, distanza 1 da “futuro” → corretto

- “di” → parola inglese valida ✓

- “miusico” → parola non valida, distanza 1 da “musica” → corretto

Risultato: La vostra domanda è corretta per “il futuro della musica”

Fase 2: Comprensione semantica (livello 2)

BERT analizza “il futuro della musica” e identifica i concetti correlati nel nostro database dei contenuti:

- “musica” (incontro esatto)

- “elettronica” (semanticamente correlato)

- “beats” (semanticamente correlati)

- “suono” (semanticamente correlato)

Risultato: Le parole chiave semantiche sono generate per una corrispondenza più ampia

Fase 3: corrispondenza dei contenuti (livello 3)

Il sistema cerca i nostri titoli video e trova:

- “Il futuro della musica elettronica nel 2026” (98% match)

- “Evoluzione musicale: Qual è il prossimo?” (85% match)

- “The Future of Sound Technology” (80% match)

Risultato: Questi titoli sono suggeriti insieme a parole chiave corrette

Cosa vedi:

testo🤖 AI Suggestions:

[the future of music] [music] [electronic]

🎬 Title Suggestions:

[The Future of Electronic Music in 2026]

[Music Evolution: What's Next?]

Attuazione tecnica: Come abbiamo costruito Questo

Lo Stack

- Indietro: PHP con classi personalizzate per l'elaborazione modulare dell'AI

- Biblioteca di AI:

transformers(Porta FMP di Hugging Face Transformers) - Database: con funzione LEVENSHTEIN personalizzata per calcoli a distanza

- Deposito di dizionario: Tavola dati dedicata con 850.000+ voci indicizzate

- Modello: Base BERT non incassata (parametri 110M, pregiato per la modellazione della lingua mascherata)

- Caching: cache in memoria per le ricerche di dizionario e previsioni BERT per ottimizzare la velocità

Ottimizzazione delle prestazioni

I modelli AI sono computazionalmente costosi. Per garantire la nostra ricerca rimane veloce, abbiamo implementato diverse ottimizzazioni:

- Prefiltrazione del dizionario: Prima di calcolare le distanze di Levenshtein, filtriamo parole per lunghezza (±2 caratteri) per ridurre lo spazio di ricerca del 90%

- Caching del risultato: I termini spesso ricercati e le loro correzioni vengono memorizzati in memoria

- Elaborazione batch: Suggerimenti multipli sono generati in una singola chiamata di inferenza BERT

Tempo medio di ricerca:< 200ms(compreso il trattamento AI)

I dati dietro l'IA

Processo di importazione del dizionario

Costruire il nostro dizionario multilingue non è stato banale. Ecco come l’abbiamo fatto:

- Raccolta dei dati: Liste di frequenza scaricate da Wiktionary, OpenSubtitles e Google Ngram per 20 lingue

- Pulizia: Rimosso caratteri speciali, URL, numeri e profanità

- Frequenza ponderazione: Valori di importanza assegnati in base alla frequenza di utilizzo

- Normalizzazione: Convertito tutte le parole in minuscolo per corrispondenza caso insensibile

- Importazione del database: Ingrandite 850.000+ voci in MySQL con colonne indicizzate per lookup veloci

Dimensione totale del database: 45MB (altamente compresso con indici)

Formazione del modello BERT

Stiamo usando il pre-allenamentobert-base-uncasedmodello, che è stato addestrato da Google su:

- LibriCorpus: 800M parole da 11.000 libri

- Wikipedia: 2.500M parole da 13GB di testo

Questo dà a BERT profonda comprensione contestuale dei modelli di lingua inglese, idiomi e relazioni semantiche.

Real-World Impact: primi risultati

Abbiamo testato il nuovo motore di ricerca internamente per le ultime due settimane. Ecco alcune metriche iniziali:

Tasso di successo di ricerca migliorato

- Prima: 67% delle ricerche restituite risultati rilevanti

- Dopo: 91% delle ricerche effettuate risultati rilevanti

- +24 punti percentuali di miglioramento

Tolleranza al tipo

- Prima: Le ricerche con 1+ typos hanno avuto 23% di successo

- Dopo: Ricerca con 1-2 tipi hanno 89% tasso di successo

- +66 miglioramento dei punti percentuali

Rilevazione multilingue

- Rileva e corregge automaticamente le domande in 20 lingue

- Ricerche italiane e spagnole hanno visto 3x aumentare le correzioni di successo

Feedback utente

I primi tester beta hanno riferito:

- “Si sente come la ricerca in realtà capisce quello che sto cercando”

- “Posso digitare rapidamente senza preoccuparsi di ortografia”

- “Finalmente! Ricerche nel lavoro italiano correttamente”

Dietro il Codice: Open Source and Transparency

Crediamo nella trasparenza. Mentre MYETV codebase è proprietaria, ci impegniamo a condividere i nostri insegnamenti con la comunità di sviluppatori. Tutto il codice utilizzato in questa implementazione è:

- 100% Open Source: Immersioni profonde nella nostra implementazione da repository github

- Open Source AI: Snippet Open-source che dimostrano l'integrazione del dizionario in PHP

- Libreria open source: i trasformatori che abbracciano la libreria per PHP sono open source su github

Perché questo Matters per te

Come utente MYETV, potresti non preoccuparti dei modelli BERT o delle distanze Levenshtein. Ma tu...volontàavviso:

- Meno frustrazione: Typos non rompe più la tua esperienza di ricerca

- Scoprizione più veloce: Trova ciò che stai cercando in meno tentativi

- Raccomandazioni migliori: Suggerimenti più rilevanti basati su ciò che realmente intendeva cercare

- Supporto multilingue: Cerca nella tua lingua madre senza preoccuparsi delle barriere linguistiche

Il nostro obiettivo è semplice:Rendere invisibile la ricerca. Non dovresti pensare a come cercare, basta trovare quello che stai cercando, istantaneamente, ogni volta.

Conclusione: Ricerca che ti capisce

Costruire un motore di ricerca AI-powered non si tratta di mostrare la tecnologia, si tratta di rimuovere l'attrito dalla vostra esperienza. Ogni tipo corretto, ogni suggerimento semantico fatto, ogni query multilingue capito è un momento in cui la tecnologia esce di strada e consente di godere di contenuti.

Abbiamo versato centinaia di ore in questo progetto: curando dizionari, modelli di formazione, ottimizzando database e algoritmi di ottimizzazione. Ma la vera misura di successo non è nel codice, è in quei momenti in cui si cerca di qualcosa, ottenere il risultato perfetto, e mai nemmeno notare che l'IA ha appena lavorato dietro le quinte per farlo accadere.

Questa è la differenza MYETV.

Benvenuti nel futuro della ricerca.

Provatelo voi stessi

Il nuovo motore di ricerca è in diretta ora su MYETV. Prova queste ricerche per vedere AI in azione:

- “la fiuture della tecnologia” (tipografie intenzionali)

- “musica elettronica” (spagnolo con typos)

- “tutorail vidio” (doppio tipo)

- Qualsiasi frase multi-parola che descrive il contenuto che si desidera trovare

Scopri come l'IA corregge, suggerisce e trova esattamente ciò che stai cercando.

Buona ricerca!

— Il team MYETV di ingegneria

Referenze tecniche

- Devlin et al., “BERT: Preformazione dei trasformatori bidirezionali profondi per la comprensione della lingua” (2018)

- Trasformatori Biblioteca:https://github.com/huggingface/transformers

- PHP Trasformatori:https://github.com/CodeWithKyrian/transformers-php

- Levenshtein Distanza:https://en.wikipedia.org/wiki/Levenshtein_distanza

- Dipendenze universali:https://universaldependencies.org/