¿Por qué?

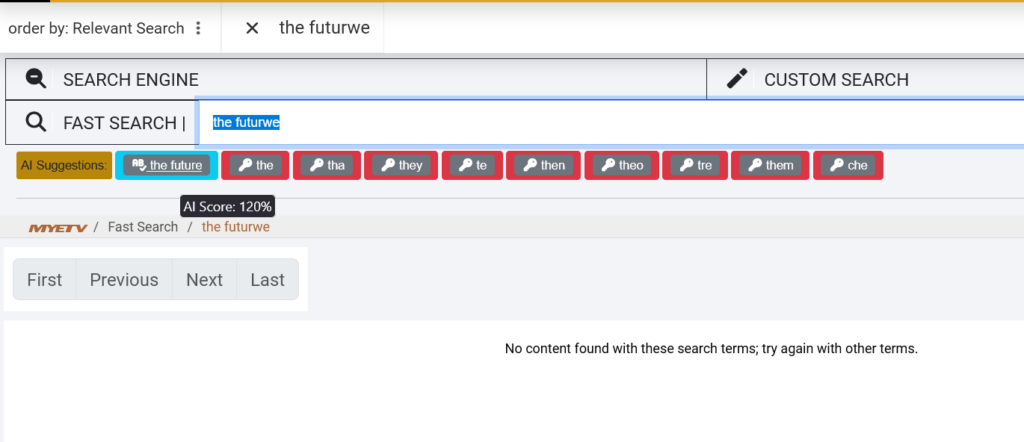

El MYETV Search Engine ya es uno de los motores de búsqueda más sofisticados de la web. La búsqueda es el latido de cualquier plataforma de contenido. Es el puente invisible entre lo que estás pensando y lo que estás tratando de encontrar. Cuando escriba “la figura de ai” en un cuadro de búsqueda, no debe obtener resultados cero sólo debido a un tipopo. Deberías conseguir exactamente lo que querías decir: “el futuro de AI”.

Hoy estamos entusiasmados de compartir un hito importante en el viaje de MYETV: una revisión completa de nuestro motor de búsqueda alimentado por inteligencia artificial, diccionarios multilingües y procesamiento avanzado del lenguaje natural. Esto no es sólo una actualización técnica, es un cambio fundamental en cómo MYETV te entiende.

Entremos en lo que construimos, por qué importa, y cómo funciona detrás de las escenas.

El problema: la búsqueda tradicional es demasiado rígida

Los motores de búsqueda tradicionales son imperdonables. Combinan palabras exactamente como las escribes. Si buscas “vídeo clásico”, la mayoría de los sistemas no devolverán nada o mostrarán resultados para algo completamente no relacionado. Ellos noentenderlenguaje, solo coinciden con patrones.

Esto se vuelve aún más problemático en una plataforma multilingüe y global como MYETV, donde los usuarios hablan inglés, italiano, español, francés, alemán, portugués y muchos otros idiomas. Un usuario en Roma podría buscar “tutorail vidio” en inglés, mientras que otro en Madrid busca “música” con un tipo como “musica” (sin acento). Los motores de búsqueda tradicionales luchan con estos escenarios del mundo real.

Nos preguntamos:¿Y si nuestro motor de búsqueda pudiera pensar como un humano?¿Y si pudiera corregir su ortografía, entender el contexto, detectar el lenguaje automáticamente, e incluso sugerir contenido basado en significado semántico en lugar de coincidencias de palabras exactas?

Eso es exactamente lo que decidimos construir.

The Solution: A Three-Layer AI-Powered Search System

Nuestro nuevo motor de búsqueda combina tres tecnologías poderosas trabajando en armonía:

1. Corrección del Diccionario Multilingüe

2. Entendimiento Semántico BERT

3. Título de conocimiento de contenido que coincide

Derribamos cada capa.

Capa 1: Corrección del Diccionario Multilingüe

La Fundación: 50.000+ Palabras en 20 idiomas

En el núcleo de nuestro nuevo motor de búsqueda es un diccionario multilingüe masivo que contiene sobre50.000 palabras cuidadosamente curadasenfrente20 idiomas. Estas no son listas de palabras aleatorias, sino que son vocabularios de frecuencia que representan cómo la gente realmente se comunica en línea.

Esto es lo que incluimos:

- Inglés: 10.000 palabras más comunes

- Italiano: 10.000 palabras más comunes

- Español: 10.000 palabras más comunes

- Francés: 10.000 palabras más comunes

- Alemán: 10.000 palabras más comunes

- portugués: 10.000 palabras más comunes

- Más 14 idiomas adicionales: Dutch, Russian, Polish, Turkish, Arabic, Chinese (Simplified), Japanese, Korean, Hindi, Swedish, Norwegian, Danish, Finnish, and Greek

Cada palabra se indexa con su frecuencia de uso, lo que significa que el sistema prioriza palabras comunes sobre palabras oscuras al sugerir correcciones.

¿De dónde vienen estos datos?

Recibimos nuestras listas de palabras de varias bases de datos lingüísticas de código abierto:

- Listas de frecuencias Wiktionary: Listas mantenidas por la comunidad de las palabras más utilizadas en cada idioma

- OpenSubtitles corpus: Uso del lenguaje del mundo real de millones de películas y series de televisión subtítulos

- Datos de Google Books Ngram: Patrones de lenguaje histórico de miles de millones de libros publicados

- Universal Dependencies treebanks: Texto anotado lingüísticamente corpora

Esta combinación nos da una imagen realista de cómo la gente realmente escribe y busca, no sólo definiciones formales de diccionario.

Cómo funciona la corrección Diccionario

Cuando escribes una consulta de búsqueda, nuestro sistema verifica inmediatamente cada palabra contra nuestro diccionario multilingüe usando una técnica llamadaLevenshtein distance, una manera matemática de medir cuántas ediciones de un solo personaje (inserciones, eliminaciones, sustituciones) son necesarias para cambiar una palabra en otra.

Por ejemplo:

- “fiuture” → “futuro” (distancia: 1, una sustitución)

- “tutorail” → “tutorial” (distancia: 1, una sustitución)

- “vidio” → “video” (distancia: 1, una sustitución)

El sistema calcula estas distancias en tiempo real, busca nuestro diccionario para palabras a una distancia de 2, las clasifica por frecuencia, y sugiere la corrección más probable.

Pero aquí está la parte inteligente: El sistema detecta automáticamente qué idioma está usando comprobando qué diccionario tiene más coincidencias para sus palabras. Si usted busca “la musica italiana” (italiano), no intentará corregirlo al inglés, reconoce italiano y valida contra el diccionario italiano en su lugar.

Capa 2: Comprensión Semántica BERT

¿Qué es BERT?

BERT significaRepresentaciones de encoder bidireccional de transformadores. Es un modelo de aprendizaje profundo desarrollado por Google que revolucionó el procesamiento del lenguaje natural en 2018. A diferencia de los motores de búsqueda tradicionales que coinciden con las palabras clave, BERT en realidadentiendeel significado de las palabras en contexto.

Piénsalo así: Si buscas “aplicar”, un motor de búsqueda tradicional no sabe si te refieres a la fruta o a la empresa tecnológica. BERT entiende el contexto. Si tus búsquedas anteriores eran sobre “iPhone” y “MacBook”, BERT sabe que probablemente te refieres a Apple Inc.

La Biblioteca Transformers

Estamos usando elBiblioteca de transformadorespor Hugging Face, que proporciona modelos de IA pre-entrenados que pueden entender y generar lenguaje humano. Específicamente, estamos utilizando:

- Modelo:

bert-base-uncased(un modelo BERT inglés compacto pero potente) - Tareas: Predicciones de la mezcla (contexto independiente para sugerir palabras relacionadas)

- Propósito: Sugerencias semánticas más allá de la corrección de ortografía

Cómo BERT mejora la búsqueda

Cuando buscas algo y no encontramos coincidencias exactas, BERT entra para sugerir términos semánticos de nuestra base de datos de contenidos.

Por ejemplo:

- Buscas: “golpes eléctricos”

- BERT sugiere: "música", "techno", "edm", "electronica"

- Usted busca: “ show de cooking”

- BERT sugiere: "receta", "chef", "culinario", "kitchen"

Esto es posible porque BERT ha sido entrenado en miles de millones de palabras y entiende las relaciones entre conceptos. No solo coincide con las letras, coincidesignificado.

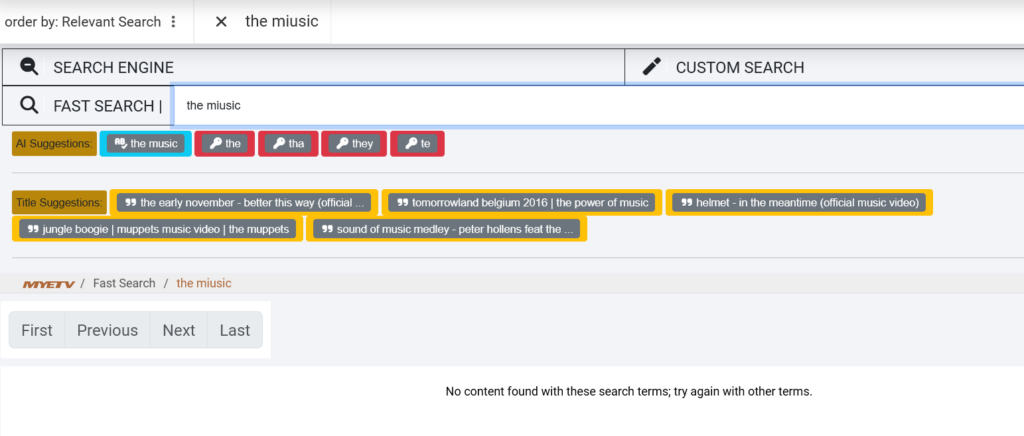

Capa 3: Título de conocimiento de contenido que coincide

Buscar dentro de los títulos, no sólo Etiquetas

La tercera capa de nuestro buscador se encuentra directamente en la biblioteca de contenidos MYETV específicamente, los títulos y descripciones de contenidos. Aquí es donde las cosas se vuelven muy inteligentes.

Cuando escribes una consulta de varias palabras como “el futuro de la música”, nuestro sistema:

- Divide tu búsqueda en palabras individuales: [“el”, “futuro”, “de”, “música”]

- Busca nuestra base de datospara títulos que contienen palabras similares

- Calcula una puntuación de similitudpara cada título basado en cuántos de sus palabras coinciden (incluso con los tipos)

- Ranks y sugierelos títulos de mejor calidad

Por ejemplo, si tenemos un video titulado “El futuro de la música electrónica en 2026”, y usted busca “la naturaleza del miusic”, el sistema:

- Correcta “fiutura” → “futuro”

- Correcto “miusic” → “music”

- Coincide “el” y “de” exactamente

- Reconocer el título como un partido del 100% y sugerirlo

Esta capa es particularmente poderosa para las búsquedas de cola larga — consultas específicas y multi-palabras que la palabra clave tradicional coincide con frecuencia falla.

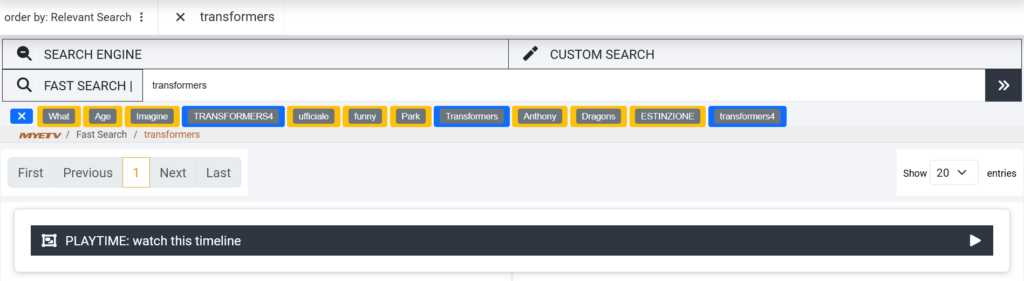

Poniéndolo todo junto: La experiencia de búsqueda

Caminemos a través de un ejemplo real para ver cómo funcionan las tres capas juntas.

Escenario: Buscas “la naturaleza de la miusica”

Paso 1: Corrección del Diccionario (Capítulo 1)

El sistema detecta:

- “el” → válido palabra Inglés ✓

- “fiuture” → palabra inválida, distancia 1 de “futuro” → corregido

- “de” → palabra Inglés válida ✓

- “miusic” → palabra inválida, distancia 1 de “music” → corregido

Resultado: Su consulta es corregida a “el futuro de la música”

Paso 2: Entendimiento Semántico (Capítulo 2)

BERT analiza “el futuro de la música” e identifica conceptos relacionados en nuestra base de datos de contenidos:

- “music” (exact match)

- “electrónica” (semántica)

- “beats” (semánticamente relacionado)

- “sonido” (semánticamente relacionado)

Resultado: Las palabras clave semánticas se generan para una combinación más amplia

Paso 3: Coincidencia de contenido (Capítulo 3)

El sistema busca nuestros títulos de vídeo y encuentra:

- “El futuro de la música electrónica en 2026” (98% partido)

- “Evolución musical: ¿Qué sigue?” (85% de coincidencia)

- “El futuro de la tecnología de sonido” (80% partido)

Resultado: Estos títulos se sugieren junto con las palabras clave corregidas

Lo que ves:

texto🤖 AI Suggestions:

[the future of music] [music] [electronic]

🎬 Title Suggestions:

[The Future of Electronic Music in 2026]

[Music Evolution: What's Next?]

Aplicación técnica: Cómo construimos Esto

El Stack

- Backend: PHP con clases personalizadas para el procesamiento modular de AI

- Biblioteca AI:

transformers(puerto de PhP de transformadores de cara hugging) - Base de datos: con función LEVENSHTEIN personalizada para cálculos de distancia

- Almacenamiento: Tabla de base de datos dedicada con 850.000 entradas indexadas

- Modelo: Base BERT sin tapa (parámetros de 110M, ajustado para modelado de lenguaje enmascarado)

- Caching: Caché de memoria para búsquedas de diccionarios y predicciones de BERT para optimizar la velocidad

Optimización del rendimiento

Los modelos AI son costosos. Para asegurar que nuestra búsqueda siga siendo rápida, implementamos varias optimizaciones:

- Diccionario: Antes de calcular distancias de Levenshtein, filtramos palabras por longitud (±2 caracteres) para reducir el espacio de búsqueda en un 90%

- Caché de resultados: Términos buscados con frecuencia y sus correcciones están caché en memoria

- Procesamiento de lotes: Múltiples sugerencias se generan en una sola llamada de inferencia BERT

Tiempo medio de búsqueda:* 200m(incluido el procesamiento de AI)

Los datos detrás de la AI

Proceso de importación

Construir nuestro diccionario multilingüe no era trivial. Así es como lo hicimos:

- Data Collection: Listas de frecuencias descargadas de Wiktionary, OpenSubtitles, y Google Ngram para 20 idiomas

- Limpieza: Quitar caracteres especiales, URL, números y profanidad

- Frecuencia Peso: Puntajes de importancia asignados basados en frecuencia de uso

- Normalización: Convertir todas las palabras en minúscula para emparejado insensible

- Importación de bases de datos: Entradas Bulk-inserted 850.000+ en MySQL con columnas indexadas para búsquedas de rayos-rápido

Tamaño total de la base de datos: 45MB (muy comprimido con índices)

BERT Model Training

Estamos usando el pre-entrenamientobert-base-uncasedmodelo, que fue entrenado por Google en:

- BooksCorpus: 800M palabras de 11.000 libros

- Wikipedia: 2.500M palabras de 13 GB de texto

Esto da a BERT comprensión contextual profunda de patrones de idioma inglés, idiomas y relaciones semánticas.

Impacto en el mundo real: resultados iniciales

Hemos estado probando el nuevo motor de búsqueda internamente durante las últimas dos semanas. Aquí hay algunas métricas tempranas:

Tasa de éxito de búsqueda mejorada

- Antes: 67% de los registros devueltos resultados relevantes

- Después: 91% de los registros devueltos resultados relevantes

- +24 puntos porcentuales mejora

Typo Tolerance

- Antes: Las búsquedas con 1+ Typos tuvieron un 23% de éxito

- Después: Las búsquedas con 1-2 tipos tienen un 89% de tasa de éxito

- +66 puntos de mejora

Detección multilingüe

- Detecta y corrige automáticamente las consultas en 20 idiomas

- Las búsquedas italianas y españolas vieron un aumento de 3x en las correcciones exitosas

Opiniones de usuarios

Early beta testers reported:

- “Se siente como que la búsqueda en realidad entiende lo que estoy buscando”

- “Puedo escribir rápidamente sin preocuparse por la ortografía”

- ¡Finalmente! Búsquedas en el trabajo italiano correctamente”

Detrás del Código: Fuente abierta y transparencia

Creemos en la transparencia. Mientras la base de código MYETV es patentada, estamos comprometidos a compartir nuestros aprendizajes con la comunidad de desarrolladores. Todo el código utilizado en esta implementación es:

- Fuente abierta 100%: Inmersiones profundas en nuestra aplicación desde repositorios github

- Open Source AI: Snippets de código abierto que demuestra la combinación de diccionarios y la integración de BERT en PHP

- Biblioteca de código abierto: la biblioteca de cara de abrazo de transformadores para PHP es fuente abierta en github

¿Por qué esto te importa?

Como usuario MYETV, es posible que no le importen los modelos BERT o distancias Levenshtein. Pero túvoluntadAviso:

- Menos frustración: Los Typos ya no rompen su experiencia de búsqueda

- Más rápido descubrimiento: Encuentra lo que estás buscando en menos intentos

- Mejores recomendaciones: Más sugerencias relevantes basadas en lo que realmente querías buscar

- Apoyo multilingüe: Buscar en su idioma nativo sin preocuparse por las barreras lingüísticas

Nuestro objetivo es simple:Hacer búsqueda invisible. No debe tener que pensar en cómo buscar, sólo debe encontrar lo que está buscando, al instante, cada vez.

Conclusión: Búsqueda que te entienda

Construir un motor de búsqueda impulsado por AI no se trata de mostrar tecnología, se trata de eliminar la fricción de su experiencia. Cada tipo corregido, cada sugerencia semántica hecha, cada consulta multilingüe entendida es un momento en el que la tecnología sale de su camino y le permite disfrutar del contenido.

Hemos derramado cientos de horas en este proyecto: curando diccionarios, modelos de entrenamiento, optimizando bases de datos y algoritmos de ajuste fino. Pero la medida real del éxito no está en el código, es en esos momentos cuando usted busca algo, obtener el resultado perfecto, y nunca siquiera notar que AI acaba de trabajar detrás de las escenas para hacer que suceda.

Esa es la diferencia MYETV.

Bienvenido al futuro de la búsqueda.

Pruébalo tú mismo.

El nuevo motor de búsqueda está en vivo ahora mismo en MYETV. Pruebe estas búsquedas para ver AI en acción:

- “la naturaleza de la tecnología” (tipos intencionales)

- “musica electronica” (Español con typos)

- “tutorail vidio” (doble typo)

- Cualquier frase de varias palabras que describa contenido que desee encontrar

Vea cómo la AI corre, sugiere y encuentra exactamente lo que está buscando.

¡Feliz búsqueda!

El Equipo de Ingeniería MYETV

Referencias técnicas

- Devlin et al., “BERT: Pre-entrenamiento de Transformadores Bidireccionales Profundos para el Entendimiento del Lenguaje” (2018)

- Transformadores Biblioteca:https://github.com/huggingface/transformers

- PHP Transformadores:https://github.com/CodeWithKyrian/transformers-php

- Levenshtein Distancia:https://en.wikipedia.org/wiki/Levenshtein_distance

- Dependencias universales:https://universaldependencies.org/