Pourquoi la recherche compte

Les MYETV Moteur de recherche est déjà l'un des moteurs de recherche les plus sophistiqués sur le web. La recherche est le cœur de toute plateforme de contenu. C'est le pont invisible entre ce que vous pensez et ce que vous essayez de trouver. Lorsque vous tapez « le fiuture d'ai ». Vous devriez obtenir exactement ce que vous vouliez dire: -l'avenir de l'IA.

Aujourd'hui, nous sommes impatients de partager une étape importante dans le voyage MYETV: une refonte complète de notre moteur de recherche alimenté par l'intelligence artificielle, les dictionnaires multilingues et le traitement avancé du langage naturel. Ce n'est pas juste une mise à jour technique, c'est un changement fondamental dans la façon dont MYETV vous comprend.

Laissez plonger dans ce que nous avons construit, pourquoi il importe, et comment il fonctionne dans les coulisses.

Le problème : la recherche traditionnelle est trop rigide

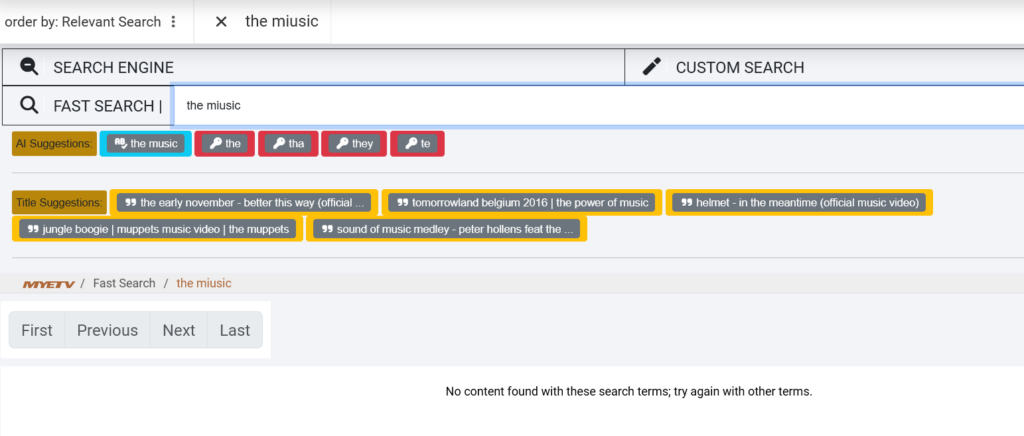

Les moteurs de recherche traditionnels sont impitoyables. Ils correspondent exactement aux mots que vous tapez. Si vous recherchez la vidéo ... ..Miusic, , la plupart des systèmes ne retourneront rien ou montreront les résultats pour quelque chose de complètement sans rapport. Ils n'ont pascomprendrelangue, ils correspondent juste aux modèles.

Cela devient encore plus problématique dans une plate-forme multilingue et mondiale comme MYETV, où les utilisateurs parlent l'anglais, l'italien, l'espagnol, le français, l'allemand, le portugais et bien d'autres langues. Un utilisateur à Rome pourrait rechercher -utoralail vidio, tandis qu'un autre à Madrid recherche -música avec un typo comme -musica (sans l'accent). Les moteurs de recherche traditionnels luttent avec ces scénarios du monde réel.

Nous nous sommes demandé :Et si notre moteur de recherche pouvait penser comme un humain ?Et si elle pouvait corriger votre orthographe, comprendre le contexte, détecter le langage automatiquement, et même suggérer du contenu basé sur la signification sémantique plutôt que des correspondances de mots exactes?

C'est exactement ce que nous avons entrepris de construire.

La solution : un système de recherche à trois niveaux alimenté par l'IA

Notre nouveau moteur de recherche combine trois technologies puissantes fonctionnant en harmonie :

1. Correction du dictionnaire multilingue

2. BERT La compréhension sémantique

3. Correspondance des titres de contenu

Découpe chaque couche.

Calque 1: Correction du dictionnaire multilingue

La Fondation : plus de 50 000 mots dans 20 langues

Au cœur de notre nouveau moteur de recherche se trouve un dictionnaire multilingue massif contenant50 000 mots soigneusement curésà travers20 langues. Ce ne sont pas seulement des listes de mots aléatoires – ce sont des vocabulaires pondérés en fréquence qui représentent la façon dont les gens communiquent réellement en ligne.

Voici ce que nous avons inclus:

- changements climatiques: 10 000 mots les plus courants

- Italien: 10 000 mots les plus courants

- Espagnol: 10 000 mots les plus courants

- Français: 10 000 mots les plus courants

- Allemand: 10 000 mots les plus courants

- Portugais: 10 000 mots les plus courants

- Plus 14 langues supplémentaires: néerlandais, russe, polonais, turc, arabe, chinois (simplifié), japonais, coréen, hindi, suédois, norvégien, danois, finnois et grec

Chaque mot est indexé avec sa fréquence d'utilisation, ce qui signifie que le système priorise les mots communs sur les mots obscurs lorsqu'il suggère des corrections.

D'où viennent ces données ?

Nous avons obtenu nos listes de mots dans plusieurs bases de données linguistiques libres :

- Listes de fréquences Wiktionary: Listes des mots les plus couramment utilisés dans chaque langue

- corpus OpenSubtitles: Utilisation de la langue du monde réel à partir de millions de sous-titres de films et d'émissions de télévision

- Google Books Données Ngram: Tendances linguistiques historiques à partir de milliards de livres publiés

- Dépendances universelles: Texte annoté linguistiquement

Cette combinaison nous donne une image réaliste de la façon dont les gens écrivent et cherchent réellement, pas seulement les définitions formelles de dictionnaire.

Comment fonctionne la correction du dictionnaire

Lorsque vous tapez une requête de recherche, notre système vérifie immédiatement chaque mot dans notre dictionnaire multilingue en utilisant une technique appeléeDistance de Levenshtein, une façon mathématique de mesurer le nombre de modifications à caractère unique (insertions, suppressions, substitutions) nécessaires pour changer un mot en un autre.

Par exemple:

- Diffuseur → Diffuseur (distance: 1, une substitution)

- TUTORAL → TUTORAL (distance: 1, une substitution)

- Description → Description (distance: 1, une substitution)

Le système calcule ces distances en temps réel, recherche les mots dans notre dictionnaire à une distance de 2, les classe par fréquence, et suggère la correction la plus probable.

Mais voici la partie intelligente: Le système détecte automatiquement quelle langue vous utilisez en vérifiant quel dictionnaire a le plus de correspondances pour vos mots. Si vous recherchez la musique italienne, elle n'a pas essayé de la corriger en anglais, elle reconnaît l'italien et valide plutôt le dictionnaire italien.

Couche 2: BERT La compréhension sémantique

Qu'est-ce que BERT ?

BERT représenteReprésentations encodeurs bidirectionnelles des transformateurs. C'est un modèle d'apprentissage profond développé par Google qui a révolutionné le traitement du langage naturel en 2018. Contrairement aux moteurs de recherche traditionnels qui correspondent à des mots-clés, BERT en faitcomprendla signification des mots en contexte.

Pensez-y comme ça : Si vous recherchez l'apple, un moteur de recherche traditionnel ne sait pas si vous voulez dire le fruit ou la société de technologie. BERT comprend le contexte. Si vos recherches précédentes étaient à propos d'iPhone et de MacBook, BERT sait que vous voulez probablement dire Apple Inc.

La bibliothèque des transformateurs

Nous utilisonsBibliothèque des transformateurspar Hugging Face, qui fournit des modèles d'IA pré-entraînement qui peuvent comprendre et générer le langage humain. Plus précisément, nous utilisons:

- Modèle:

bert-base-uncased(modèle BERT anglais compact mais puissant) - Tâche: Fill-mask prédictions (comprendre le contexte pour suggérer des mots apparentés)

- Objet: Suggestions sémantiques au-delà de la correction orthographique

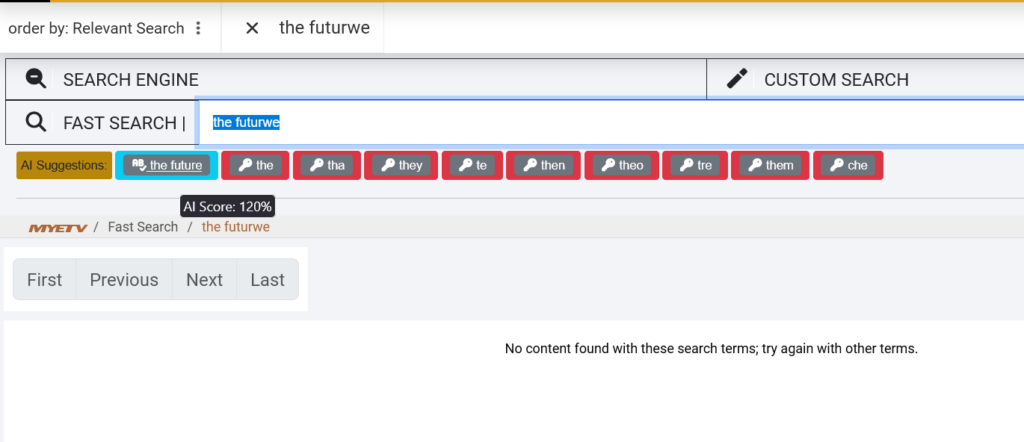

Comment BERT améliore la recherche

Lorsque vous recherchez quelque chose et que nous ne trouvons pas des correspondances exactes, BERT intervient pour suggérer des termes liés sémantiquement à partir de notre base de données de contenu.

Par exemple:

- Vous recherchez: -

- BERT suggère: Musique,

- Vous recherchez:

- BERT suggère:

Cela est possible parce que BERT a été formé à des milliards de mots et comprend les relations entre les concepts. Il ne correspond pas juste aux lettres, il correspondsignification.

Calque 3: Correspondance des titres de contenu

Recherche dans les titres, pas seulement les étiquettes

La troisième couche de notre moteur de recherche regarde directement dans MYETVS la bibliothèque de contenu spécifiquement, les titres et les descriptions de contenu. C'est là que les choses deviennent vraiment intelligentes.

Lorsque vous tapez une requête multi-mots comme le futur de la musique,

- Sépare votre requête en mots individuels: [..]

- Recherche dans notre base de donnéespour les titres contenant des mots similaires

- Calcule un score de similitudepour chaque titre basé sur le nombre de vos mots (même avec typos)

- Classements et suggestionsles titres les mieux appariés

Par exemple, si nous avons une vidéo intitulée "L'avenir de la musique électronique en 2026," et que vous recherchez "le futur de miusic," le système:

- Correcte : __fiuture → __future

- C'est exact, c'est exact.

- Correspondant exactement à la

- Reconnaître le titre comme un match à 100% et le suggérer

Cette couche est particulièrement puissante pour les recherches à longue queue – des requêtes spécifiques à plusieurs mots que les mots-clés traditionnels ne correspondent pas souvent.

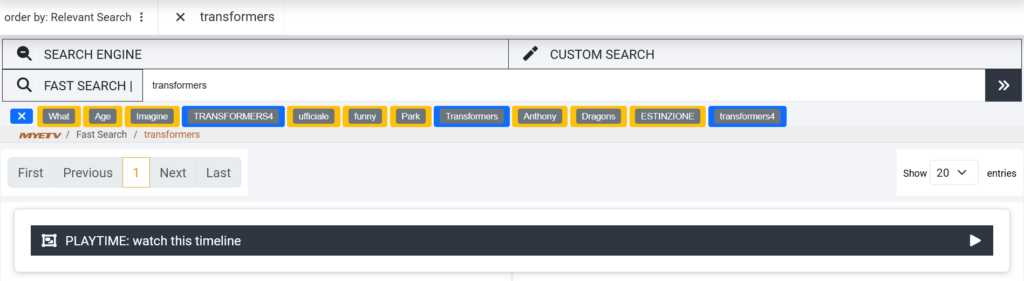

Tout mettre ensemble : l'expérience de recherche

Laissez passer un exemple réel pour voir comment les trois couches fonctionnent ensemble.

Scénario : Vous recherchez le futur de Miusic

Étape 1 : Correction du dictionnaire (Layer 1)

Le système détecte:

- → mot anglais valide

- Lire la suite → mot invalide, distance 1 à partir de lire la suite → corrigé

- → mot anglais valide ✓

- Lire la suite → mot invalide, distance 1 de la musique → corrigé

Résultat: Votre requête est corrigée à l'avenir de la musique

Étape 2: Compréhension sémantique (Layer 2)

BERT analyse l'avenir de la musique et identifie les concepts connexes dans notre base de données de contenu :

- Musique (comparaison exacte)

- Électronique

- (séminairement lié)

- "Sound" (lié à la sématisation)

Résultat: Mots-clés sémantiques sont générés pour une correspondance plus large

Étape 3: Correspondance du contenu (Layer 3)

Le système recherche nos titres vidéo et trouve:

- L'avenir de la musique électronique en 2026

- Évolution de la musique : Quoi de neuf ?

- L'avenir de la technologie sonore (80% match)

Résultat: Ces titres sont suggérés avec des mots-clés corrigés

Ce que vous voyez :

texte🤖 AI Suggestions:

[the future of music] [music] [electronic]

🎬 Title Suggestions:

[The Future of Electronic Music in 2026]

[Music Evolution: What's Next?]

Mise en oeuvre technique : Comment nous avons construit Cette

La pile

- Moteur: PHP avec des classes personnalisées pour le traitement modulaire de l'IA

- Bibliothèque AI:

transformers(Port PSP des Transformateurs de visages) - Base de données: avec la fonction LEVENSHTEIN personnalisée pour les calculs de distance

- Stockage des dictionnaires: Table de base de données dédiée avec 850 000 entrées indexées

- Modèle: Base BERT non casée (paramètres 110M, affinés pour la modélisation du langage masqué)

- Cache: cache en mémoire pour les recherches de dictionnaires et les prédictions BERT pour optimiser la vitesse

Optimisation des performances

Les modèles d'IA coûtent cher. Pour garantir que notre recherche reste rapide, nous avons mis en œuvre plusieurs optimisations :

- Dictionnaire Préfiltrage: Avant de calculer les distances de Levenshtein, nous filtrant les mots par longueur (±2 caractères) pour réduire l'espace de recherche de 90%

- Cache des résultats: Termes fréquemment recherchés et leurs corrections sont mises en cache en mémoire

- Traitement par lots: Plusieurs suggestions sont générées dans un seul appel à inférence BERT

Temps moyen de recherche:< 200 ms(y compris le traitement de l'IA)

Les données derrière l'IA

Processus d'importation du dictionnaire

Construire notre dictionnaire multilingue n'était pas trivial. Voici comment nous l'avons fait:

- Collecte de données: Listes de fréquences téléchargées de Wiktionary, OpenSubtitles et Google Ngram pour 20 langues

- Nettoyage: Supprimé caractères spéciaux, URLs, nombres, et profanité

- Pondération de la fréquence: scores d'importance assignés en fonction de la fréquence d'utilisation

- Normalisation: Converti tous les mots en minuscules pour une correspondance insensible aux cas

- Importation de la base de données: Insertion en vrac 850 000+ entrées dans MySQL avec colonnes indexées pour la recherche rapide

Taille totale des bases de données: 45 Mo (fortement comprimé avec des index)

Formation modèle BERT

Nous utilisons le pré-entraînementbert-base-uncasedmodèle, qui a été formé par Google sur:

- LivresCorpus: 800 M mots de 11 000 livres

- Wikipedia Français: 2 500 millions de mots de 13 Go de texte

Cela donne au BERT une compréhension contextuelle profonde des modèles de langue anglaise, des idiomes et des relations sémantiques.

Impact sur le monde réel : premiers résultats

Nous avons testé le nouveau moteur de recherche en interne depuis deux semaines. Voici quelques premiers paramètres :

Amélioration du taux de réussite de la recherche

- Avant: 67% des recherches ont retourné les résultats pertinents

- Après: 91% des résultats de recherche retournés

- +24 points d'amélioration

Tolérance au typo

- Avant: Les recherches avec 1+ typos ont eu un taux de réussite de 23%

- Après: Les recherches avec 1-2 typos ont un taux de réussite de 89%

- +66 points de pourcentage

Détection multilingue

- Détecte et corrige automatiquement les requêtes en 20 langues

- Les recherches italiennes et espagnoles ont enregistré une augmentation de 3x des corrections réussies

Commentaires des utilisateurs

Les premiers bêta-testeurs ont rapporté:

- C'est comme si la recherche comprenait ce que je cherche

- Je peux taper rapidement sans m'inquiéter de l'orthographe

- Enfin ! Recherches en italien travail correctement

Derrière le Code : Open Source et transparence

Nous croyons en la transparence. Alors que MYETVS codebase est propriétaire, nous sommes engagés à partager nos apprentissages avec la communauté de développeurs. Tout le code utilisé dans cette implémentation est :

- 100% Open Source: Deep plonge dans notre implémentation à partir des dépôts github

- Source ouverte AI: Extraits de dictionnaires open-source démontrant la correspondance et l'intégration BERT en PHP

- Bibliothèque Open Source: la bibliothèque des transformateurs câlins pour PHP est open source sur github

Pourquoi cela compte pour vous

En tant qu'utilisateur MYETV, il se peut que vous ne vous souciiez pas des modèles BERT ou des distances Levenshtein. Mais toiseraavis:

- Moins de frustration: Typos ne rompt plus votre expérience de recherche

- Découverte plus rapide: Trouvez ce que vous cherchez en moins de tentatives

- Meilleures recommandations: Suggestions plus pertinentes basées sur ce que vous entendiez réellement rechercher

- Appui multilingue: Rechercher dans votre langue maternelle sans s'inquiéter des barrières linguistiques

Notre objectif est simple :Rendre la recherche invisible. Vous ne devriez pas avoir à penser à la façon de rechercher, vous devriez juste trouver ce que vous cherchez, instantanément, à chaque fois.

Conclusion : Recherche qui vous comprend

Construire un moteur de recherche à moteur d'IA n'est pas à propos de montrer la technologie, il est à propos d'éliminer les frictions de votre expérience. Chaque typo corrigé, chaque suggestion sémantique faite, chaque requête multilingue comprise est un moment où la technologie s'éloigne de votre chemin et vous permet d'apprécier le contenu.

Nous avons consacré des centaines d'heures à ce projet : dictionnaires curatifs, modèles de formation, bases de données optimisées et algorithmes de réglage fin. Mais la vraie mesure du succès n'est pas dans le code, il est dans les moments où vous recherchez quelque chose, obtenir le résultat parfait, et ne jamais remarquer que l'IA a juste travaillé dans les coulisses pour le faire arriver.

C'est la différence MYETV.

Bienvenue dans l'avenir de la recherche.

Essaie toi-même

Le nouveau moteur de recherche est en direct sur MYETV. Essayez ces recherches pour voir l'IA en action:

- Le futur de la tectnologie (types intentionnels)

- (Espagnol avec typos)

- (double typo)

- Toute phrase multi-mots décrivant le contenu que vous voulez trouver

Voyez comment l'IA corrige, suggère et trouve exactement ce que vous cherchez.

Bonne recherche !

— L'équipe d'ingénierie MYETV

Références techniques

- BERT: Devlin et al., ☆BERT: Pré-formation des transformateurs bidirectionnels profonds pour la compréhension des langues (2018)

- Transformateurs Bibliothèque :https://github.com/huggingface/transformers

- PHP Transformateurs:https://github.com/CodeWithKyrian/transformers-php

- Levenshtein Distance:https://en.wikipedia.org/wiki/Levenshtein_distance

- Dépendances universelles:https://universaldependences.org/