Warum Recherchenangelegenheiten

Das [PH_AF3FD128) Suchmaschine ist bereits eine der anspruchsvollsten Suchmaschinen im Web. Suche ist der Herzschlag jeder Content- [Contents: every content intended as text, images, audio or video] - -Plattform. Es ist die unsichtbare Brücke zwischen dem, was Sie denken und was Sie versuchen zu finden. Wenn Sie die Fiuture von ai / ai in ein Suchfeld eingeben, sollten Sie nicht Null Ergebnisse nur wegen eines Tippfehlers erhalten. Sie sollten genau erhalten, was Sie meinten: die Zukunft von AI.

Heute freuen wir uns, einen wichtigen Meilenstein in MYETVs Reise zu teilen: eine komplette Überholung unserer Suchmaschine, die durch künstliche Intelligenz, mehrsprachige Wörterbücher und fortgeschrittene natürliche Sprachverarbeitung angetrieben wird. Dies ist nicht nur ein technisches Upgrade, es ist eine grundlegende Verschiebung in, wie MYETV Sie versteht.

Lasst uns in das tauchen, was wir gebaut haben, warum es wichtig ist, und wie es hinter den Kulissen funktioniert.

Das Problem: Traditionelle Suche ist zu starr

Traditionelle Suchmaschinen sind unverzeihlich. Sie stimmen mit Worten überein, wie Sie sie tippen. Wenn Sie nach Ã1⁄4brigen Video suchen, werden die meisten Systeme entweder nichts zurückgeben oder Ergebnisse fÃ1⁄4r etwas völlig Nichts zeigen. Sie tun es nichtverstehenSprache, sie entsprechen nur Mustern.

Noch problematischer wird dies in einer mehrsprachigen, globalen Plattform wie MYETV, wo Nutzer Englisch, Italienisch, Spanisch, Französisch, Deutsch, Portugiesisch und viele andere Sprachen sprechen. Ein User in Rom könnte auf Englisch nach Ã1⁄4bersetzten Vidio Ã1⁄4berfahren, während ein anderer in Madrid nach Ã1⁄4bersetzten à berschriften sucht. Traditionelle Suchmaschinen kämpfen mit diesen realen Szenarien.

Wir fragten uns:Was, wenn unsere Suchmaschine wie ein Mensch denken könnte?Was, wenn es Ihre Rechtschreibung korrigieren, Kontext verstehen, Sprache automatisch erkennen und sogar Inhalte vorschlagen könnte, die auf semantischer Bedeutung basieren, anstatt exakte Wortspiele?

Das ist genau das, was wir geplant haben, um zu bauen.

Die Lösung: Ein dreilagiges KI-Powered Search System

Unsere neue Suchmaschine vereint drei leistungsstarke Technologien, die in Harmonie arbeiten:

1. Mehrsprachige Korrektur des Wörterbuchs

2. BERT semantisches Verständnis

3. Content-Aware Title Matching

Lassen Sie die einzelnen Ebenen niederbrechen.

Schicht 1: Mehrsprachige Korrektur des Wörterbuchs

Die Stiftung: 50.000+ Wörter in 20 Sprachen

Im Kern unserer neuen Suchmaschine ist ein massives mehrsprachiges Wörterbuch mit über50.000 sorgfältig kuratierte Wörterquer20 Sprachen. Diese sind nicht nur zufällige Wortlisten sie frequenzgewichtete Vokabeln, die darstellen, wie Menschen tatsächlich online kommunizieren.

Hier ist, was wir enthalten:

- Englisch: 10.000 häufigste Wörter

- Italienisch: 10.000 häufigste Wörter

- Spanisch: 10.000 häufigste Wörter

- Französisch: 10.000 häufigste Wörter

- Deutsch: 10.000 häufigste Wörter

- Portugiesisch: 10.000 häufigste Wörter

- Plus 14 weitere Sprachen: Niederländisch, Russisch, Polnisch, Türkisch, Arabisch, Chinesisch (vereinfacht), Japanisch, Koreanisch, Hindi, Schwedisch, Norwegisch, Dänisch, Finnisch und Griechisch

Jedes Wort wird mit seiner Nutzungshäufigkeit indiziert, was bedeutet, dass das System allgemeine Wörter über obskure Wörter priorisiert, wenn es Korrekturen vorschlägt.

Woher kamen diese Daten?

Wir haben unsere Wortlisten aus mehreren open-sourcen Sprachdatenbanken bezogen:

- Wiktionäre Frequenzlisten: Gemeinschaftliche Liste der am häufigsten verwendeten Wörter in jeder Sprache

- OpenSubtitles corpus: Real-world Sprachnutzung von Millionen von Film- und Fernsehuntertiteln

- Daten von Google Books Ngram: Historische Sprachmuster aus Milliarden veröffentlichter Bücher

- Universale Abhängigkeiten Baumbanken: Linguistisch annotierte Textkorpora

Diese Kombination gibt uns ein realistisches Bild davon, wie Menschen tatsächlich schreiben und suchen, nicht nur formale Wörterbuchdefinitionen.

Wie funktioniert die Korrektur des Wörterbuchs?

Wenn Sie eine Suchabfrage eingeben, prüft unser System sofort jedes Wort gegen unser mehrsprachiges Wörterbuch mit einer Technik namensLevenshtein Entfernung, ein mathematischer Weg, um zu messen, wie viele Single-Charakter-Editionen (Einfügungen, Löschungen, Substitutionen) benötigt werden, um ein Wort in ein anderes zu ändern.

Zum Beispiel:

- (Entfernung: 1, eine Substitution)

- (Entfernung: 1, eine Substitution)

- (Entfernung: 1, eine Substitution)

Das System berechnet diese Entfernungen in Echtzeit, sucht unser Wörterbuch nach Wörtern innerhalb einer Entfernung von 2, ordnet sie nach Häufigkeit und schlägt die wahrscheinlichste Korrektur vor.

Aber hier ist der clevere Teil: Das System erkennt automatisch, welche Sprache Sie verwenden, indem Sie überprüfen, welches Wörterbuch die meisten Übereinstimmungen für Ihre Wörter hat. Wenn Sie suchen, die italienische musica italienisch (italienisch), es wird versucht, es auf Englisch zu korrigieren, erkennt es Italienisch und validiert gegen das italienische Wörterbuch statt.

Ebene 2: BERT Semantisches Verständnis

Was ist BERT?

BERT steht fürBidirektionale Encoderdarstellungen von Transformatoren. Es ist ein von Google entwickeltes Deep-Learning-Modell, das die Verarbeitung natürlicher Sprache 2018 revolutionierte. Im Gegensatz zu traditionellen Suchmaschinen, die Keywords entsprechen, BERT tatsächlichverstehtdie Bedeutung von Wörtern im Kontext.

Denken Sie so: Wenn Sie für Ã1⁄4berraschen, Ã1⁄4ber eine traditionelle Suchmaschine nicht wissen, ob Sie die Frucht oder die Tech-Firma bedeuten. BERT versteht Kontext. Wenn Ihre vorherigen Suchanfragen über Ã1⁄4ber Ã1⁄4ber Ã1⁄4ber Ã1⁄4ber Ã1⁄4ber Ã1⁄4ber MacBook , BERT weiß, dass Sie wahrscheinlich Apple Inc.

Die Transformers Library

Wir verwenden dasTransformatoren-Bibliothekdurch Hugging Face, die vortrainierte KI-Modelle bietet, die menschliche Sprache verstehen und generieren können. Konkret verwenden wir:

- Modell:

bert-base-uncased(ein kompaktes, aber leistungsstarkes englisches BERT-Modell) - Aufgabe: Fill-Mask Vorhersagen (Verstehen Kontext, um verwandte Wörter vorschlagen)

- Zweck: Semantische Vorschläge über Rechtschreibkorrektur hinaus

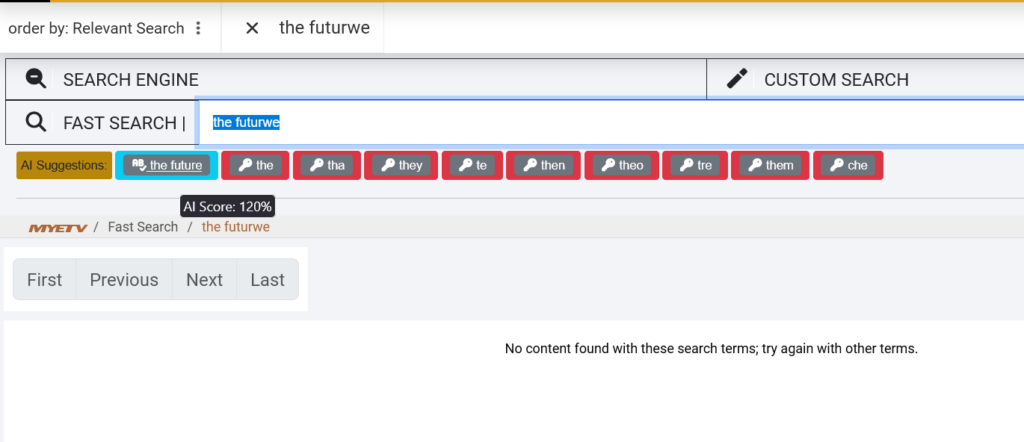

Wie BERT die Suche verbessert

Wenn Sie nach etwas suchen und wir keine genauen Übereinstimmungen finden, geht BERT ein, um semantisch verwandte Begriffe aus unserer Content-Datenbank vorzuschlagen.

Zum Beispiel:

- Sie suchen:

- BERT schlägt vor: Ã1⁄4bersetzung, Ã1⁄4bersetzung, Ã1⁄4bersetzung,

- Sie suchen:

- BERT schlägt vor: Ã1⁄4bergang, Ã1⁄4bergang, Ã1⁄4bergang, Ã1⁄4bergang

Das ist möglich, weil BERT auf Milliarden von Wörtern ausgebildet wurde und Beziehungen zwischen Konzepten versteht. Es passt nicht nur Buchstaben, es passtBedeutung.

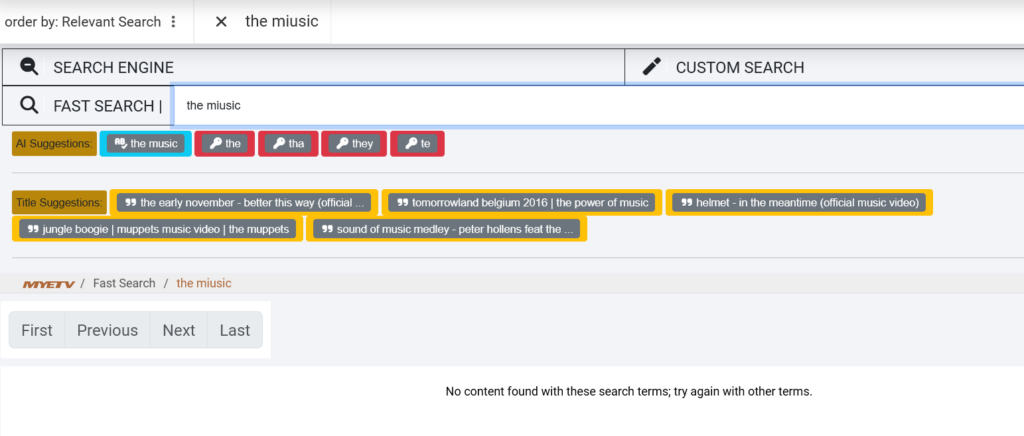

Ebene 3: Inhalt-Aware Titel passend

Inside Titel suchen, nicht nur Tags

Die dritte Ebene unserer Suchmaschine schaut direkt in MYETVs Inhaltsbibliothek speziell, die Titel und Beschreibungen von Inhalten. Hier wird es wirklich schlau.

Wenn Sie eine Multi-Wort-Abfrage wie die Zukunft der Musik eingeben, unser System:

- Teilt Ihre Abfrage in einzelne Wörter: [Der Scheiß, Zukünftige, Von der Musik]

- Durchsucht unsere Datenbankfür Titel mit ähnlichen Wörtern

- Berechnet eine Ähnlichkeitszahlfür jeden Titel, basierend auf wie vielen Wörtern (auch mit Tippfehlern)

- Rangliste und Vorschlägedie besten Titel

Zum Beispiel, wenn wir ein Video mit dem Titel "Die Zukunft der elektronischen Musik im Jahr 2026" haben, und Sie suchen die Fiuture von miusic, das System wird:

- Korrekte Fiuture → Zukunft

- Korrekte Musik → Musik

- Spiel genau

- Erkenne den Titel als 100%-Match und schlage ihn vor

Diese Schicht ist besonders leistungsstark für Langschwanz-Suchen Ã1⁄4ber spezifische, Multi-Wort-Abfragen, die traditionelle Keyword-Matching oft fehlt.

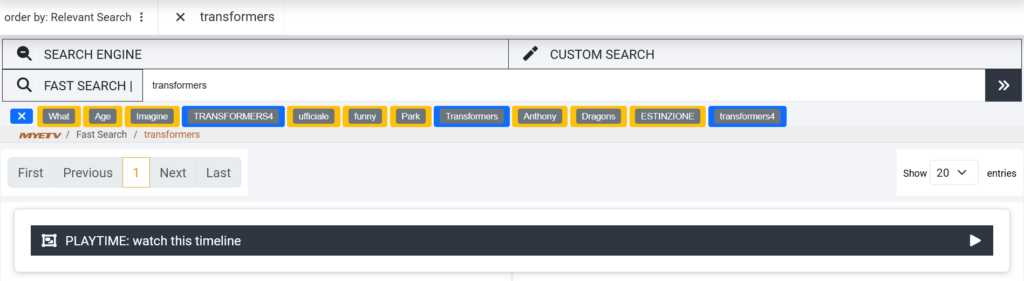

Alles zusammenstellen: Die Sucherfahrung

Lasst sie durch ein echtes Beispiel gehen, um zu sehen, wie alle drei Schichten zusammen arbeiten.

Szenario: Sie suchen nach der Fiuture von miusic

Schritt 1: Korrektur des Wörterbuchs (Layer 1)

Das System erkennt:

- Das → gültige englische Wort ✓

- Ungültiges Wort, Entfernung 1 von der Zukunft → korrigiert

- Englisches Wort ✓

- Ungültiges Wort, Entfernung 1 von der Musik → korrigiert

Ergebnis: Ihre Anfrage wird auf die Zukunft der Musik korrigiert

Schritt 2: Semantisches Verständnis (Layer 2)

BERT analysiert die Zukunft der Musik und identifiziert verwandte Konzepte in unserer Content-Datenbank:

- (genaues Spiel)

- E-Mail-Adresse

- (semantisch verwandt)

- (semantisch verwandt)

Ergebnis: Semantische Schlüsselwörter werden für breitere Matching generiert

Schritt 3: Inhalt passend (Layer 3)

Das System durchsucht unsere Videotitel und findet:

- Die Zukunft der elektronischen Musik im Jahr 2026 (98% Spiel)

- Musikalische Evolution: Was sind die nächsten?

- Die Zukunft der Tontechnik (80% Match)

Ergebnis: Diese Titel werden neben korrigierten Schlüsselwörtern vorgeschlagen

Was Sie sehen:

Text🤖 AI Suggestions:

[the future of music] [music] [electronic]

🎬 Title Suggestions:

[The Future of Electronic Music in 2026]

[Music Evolution: What's Next?]

Technische Umsetzung: Wie wir gebaut haben Dies

Der Stack

- Backend: PHP mit benutzerdefinierten Klassen für die modulare KI-Verarbeitung

- KI-Bibliothek:

transformers(PHP-Port von Hugging Face Transformers) - Datenbank: mit benutzerdefinierter LEVENSHTEIN-Funktion für Distanzberechnungen

- Speicher von Wörterbüchern: Dedizierte Datenbanktabelle mit 850.000+ indexierten Einträgen

- Modell: BERT Basis uncased (110M Parameter, fein abgestimmt für maskierte Sprachmodellierung)

- Caching: In-Memory-Cache für Wörterbuch-Lookups und BERT-Voraussagen zur Optimierung der Geschwindigkeit

Leistungsoptimierung

KI-Modelle sind kalkuliert teuer. Damit unsere Suche schnell bleibt, haben wir mehrere Optimierungen umgesetzt:

- Vorfilterung des Wörterbuchs: Vor der Berechnung der Levenshtein-Abstände filtern wir Wörter nach Länge (±2 Zeichen), um den Suchraum um 90% zu reduzieren

- Ergebnis Caching: Häufig gesuchte Begriffe und deren Korrekturen werden im Speicher gespeichert

- Chargenverarbeitung: Mehrere Vorschläge werden in einem einzigen BERT Inference Call generiert

Durchschnittliche Suchzeit:< 200ms(einschließlich KI-Verarbeitung)

Die Daten hinter der KI

Importprozess des Wörterbuchs

Unser mehrsprachiges Wörterbuch zu bauen war nicht trivial. Hier ist, wie wir es getan haben:

- Datenerhebung: Heruntergeladene Frequenzlisten von Wiktionary, OpenSubtitles und Google Ngram für 20 Sprachen

- Reinigung: Entfernte Sonderzeichen, URLs, Zahlen und Profanität

- Frequenzgewichtung: Assigned relevant scores based on use frequency

- Normalisierung: Konvertiert alle Wörter in Kleinbuchstaben für Case-insensitive Matching

- Datenbankimport: Bulk-inserted 850.000+ Einträge in MySQL mit indizierten Spalten für Blitzschnell-Lookups

Datenbankgröße insgesamt: 45MB (sehr komprimiert mit Indizes)

BERT Modellausbildung

Wir verwenden die vortrainiertenbert-base-uncasedModell, das von Google auf trainiert wurde:

- BücherKorpus: 800M Wörter aus 11.000 Büchern

- Englische Wikipedia: 2.500M Wörter aus 13GB Text

Dies gibt BERT tiefes kontextuelles Verständnis von englischen Sprachmustern, Idiomen und semantischen Beziehungen.

Real-World Impact: Frühe Ergebnisse

Wir haben die neue Suchmaschine intern für die letzten zwei Wochen getestet. Hier sind einige frühe Metriken:

Verbesserte Sucherfolgsrate

- Vorher67% der Suchen lieferten relevante Ergebnisse

- Nach: 91% der Suchen lieferten relevante Ergebnisse

- Verbesserung um 24 Prozentpunkte

Typo Toleranz

- Vorher: Suchen mit 1+ Tippfehlern hatten 23% Erfolgsrate

- Nach: Suchen mit 1-2 Typos haben 89% Erfolgsrate

- Verbesserung um +66 Prozentpunkte

Mehrsprachige Erkennung

- Automatische Erkennung und Korrektur von Abfragen in 20 Sprachen

- Italienische und spanische Recherchen sahen 3x Anstieg der erfolgreichen Korrekturen

Benutzerfeedback

Frühe Betatester berichteten:

- Es fühlt sich an wie die Suche tatsächlich versteht, was ich suche

- Ich kann schnell tippen, ohne mir Sorgen um Rechtschreibung zu machen

- Endlich! Suchen in der italienischen Arbeit richtig

Hinter dem Code: Open Source und Transparenz

Wir glauben an Transparenz. Während MYETV-Codebase proprietär ist, verpflichten wir uns, unser Lernen mit der Entwicklergemeinschaft zu teilen. Der in dieser Implementierung verwendete Code lautet:

- 100% Open Source: Tiefe Tauchgänge in unsere Implementierung von Github Repositorys

- Open Source AI: Open-Source-Snippets, die Wörterbuch-Matching und BERT-Integration in PHP demonstrieren

- Open Source Bibliothek: die Transformator-Umarmungsbibliothek für PHP ist Open Source auf Github

Warum das für Sie wichtig ist

Als MYETV Benutzer kümmern Sie sich möglicherweise nicht um BERT-Modelle oder Levenshtein-Distanzen. Aber duwirdHinweis:

- Weniger Frustration: Tipos brechen nicht mehr Ihre Sucherfahrung

- Schnellere Entdeckung: Finden Sie, was Sie suchen in weniger Versuchen

- Bessere Empfehlungen: Weitere relevante Vorschläge basierend auf dem, was Sie eigentlich suchen wollten

- Mehrsprachige Unterstützung: Suche in deiner Muttersprache ohne Sorge um Sprachbarrieren

Unser Ziel ist einfach:Suche unsichtbar machen. Sie sollten nicht darüber nachdenken, wie man sucht, sollten Sie gerade finden, was Sie suchen, sofort, jedes Mal.

Fazit: Suche, die Sie versteht

Aufbau einer KI-betriebenen Suchmaschine ist nicht über das Ausblenden der Technologie, es ist über das Entfernen von Reibung von Ihrer Erfahrung. Jeder Typo korrigiert, jeder semantische Vorschlag gemacht, jede mehrsprachige Abfrage verstanden ist ein Moment, wo Technologie aus Ihrem Weg kommt und Sie genießen Inhalte.

Wir haben Hunderte von Stunden in dieses Projekt gegossen: das Kuratieren von Wörterbüchern, Trainingsmodellen, die Optimierung von Datenbanken und Feinabstimmungsalgorithmen. Aber das wahre Maß des Erfolgs ist nicht im Code, es ist in diesen Momenten, wenn Sie nach etwas suchen, erhalten das perfekte Ergebnis, und nie sogar bemerken, dass KI gerade hinter den Kulissen gearbeitet, um es geschehen zu lassen.

Das ist der MYETV Unterschied.

Willkommen in der Zukunft der Suche.

Versuchen Sie es selbst

Die neue Suchmaschine ist jetzt live auf MYETV. Versuchen Sie diese Suchen, um KI in Aktion zu sehen:

- Die Figue der Tecnologie

- (Spanisch mit Typos)

- Vidio-Tutorail (Doppeltypo)

- Jede mehrwortige Phrase, die Inhalte beschreibt, die Sie finden möchten

Sehen Sie, wie die KI korrigiert, schlägt vor, und findet genau, was Sie suchen.

Frohe Suche!

Das MYETV Engineering Team

Technische Referenzen

- Devlin et al., Vortraining von Deep Bidirectional Transformers for Language Understanding (2018)

- Transformatoren Bibliothek:https://github.com/huggingface/transformers

- PHP Transformatoren:https://github.com/CodeWithKyrian/transformers-php

- Levenshtein Entfernung:https://de.wikipedia.org/wiki/Levenshtein_distance

- Allgemeine Abhängigkeiten:https://universaldependences.org/